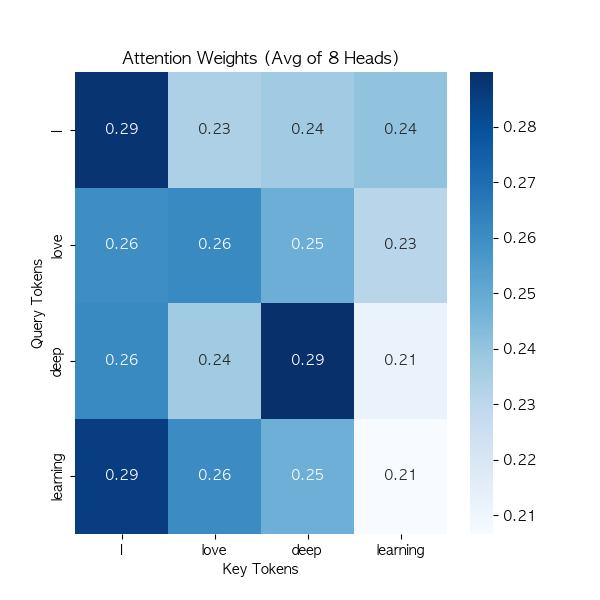

Attention 메커니즘 시퀀스 데이터에서 중요한 부분에 더 많은 가중치를 할당하여 정보를 효율적으로 처리하는 기법주로 자연어 처리(NLP) 및 시계열 데이터에서 사용되며, 기계 번역, 요약, 질의응답 시스템 등에 적용됨 동작 방식 기본 개념입력 시퀀스의 각 요소에 대해 중요도를 계산하여 가중치를 부여불필요한 정보를 무시하고 중요한 정보 강조 주요 구성 요소 : Query(Q), Key(K), Value(V) 1. Attention 스코어 계산 Query와 Key 간의 유사도를 측정하여 중요도를 계산일반적으로 내적(dot product) 연산을 사용하여 유사도를 계산함𝓢(Q, K) = Q · K^T 2. Softmax를 통한 가중치 계산 Attention 스코어를 Softmax 함수로 정규화하여..